신개념 유저 인터페이스 ‘G-speak’과 ‘eyeCan’를 보다!!

만약 인터넷을 눈 동작으로 구동할 수 있다면!! 그리고 마이너리티 리포트 처럼 공간 터치가 가능해져 키보드가 필요없어진다면~~

상상만해도 편리한 세상일 것 같은데요~~

이같은 작업이 현재 대학과 기업에서 활발히 연구중에 있다고 합니다.

마이너리티 리포트(2002년)가 개봉된지도 10년째인데요~~

그럼에도 불구하고 주인공 톰크루즈가 손동작으로 미래 일어날 범행 장면을 보는 모습은 미래 디스플레이의 결정판을 보여주는 최적의 예가 아닐까 생각합니다.

<사진 : NAVER>

그런데 아쉽게도 영화는 영화겠죠?

라고 ~~ 하시는 분들은 기술의 변화 속도에 대해 이 글을 보시면 놀라움을 금치 못하실 겁니다.

요즘 우리는 터치 기술이 등장해 유비쿼터스 환경에서 자유롭게 정보를 입력할 수 있게 되었습니다.

바로 터치 기능이 내장된 갤럭시 노트 등 스마트 IT기기들의 등장 때문인데요!

우리가 사용하고 있는 대부분의 스마트 IT기기들은 ‘Finger Touch’타입이죠 ~~

오늘 소개할 내용은 바로 미래의 유저인터페이스인 ‘G-speak’입니다.

이 기술이 보여주는 미래가 바로 우리가 10년전 신기하게 봐왔던 마이너리티 리포트의 기술과 같다는 것입니다.ㅎㅎ

물론 이 기술을 모티브로 영화를 제작했는지 아님 반대인지는 정확히 모르겠지만 중요한 것은 미래 기술이 우리도 모르는 사이 빠르게 현재 기술을 대체하려고 한다는 것이죠!!

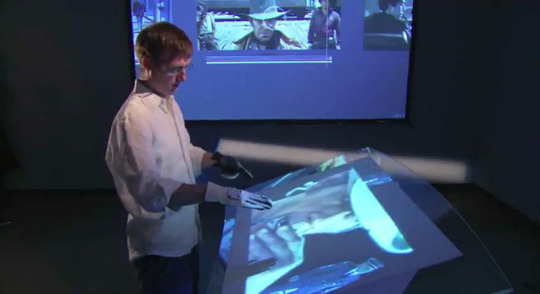

아래 동영상은 TED에 존 언더코플러(John Underkoffler) 교수가 나와 직접 G-speak 기술에 대해 설명하고 대중앞에서 시연하는 모습입니다.

<동영상 : TED>

동영상을 보시면 유저의 주위를 둘러싼 3D 카메라가 설치되어 있는데요!!

이는 공간 안에서 일어나는 사용자의 움직임을 3D 좌표로 변환할 수 있도록 한다고 합니다.

<동영상 : TED>

유저는 손에 동작 인식이 가능한 모션 센서가 부착된 장갑을 끼는데요~~ G-speak의 경우는

엄지, 검지, 중지와 손등에 각각 센서가 달려있다고 합니다~~

손등의 센서는 손의 위치를 파악하고 세 손가락에 부착된 센서로는 손가락으로 만드는

3D 제스처를 명령어로 변환시킨다고 합니다.

<동영상 : TED>

즉 자기가 원하는 손가락 동작을 만든후 명령어로 저장하기만 하면 된다고 합니다.

이 시스템은 사용자의 3D 제스처를 캡쳐해 인식하기 때문에 공간안의 어느 위치든 디스플레이 패널만 설치하면 이 디스플레이와 상호 작용할 수 있다네요~~

또 정면에 위치한 화면에 있는 물체를 손가락으로 집어서 바닥에 있는 화면에 옮겨올 수도 있다고 하니~~ 정말 감탄을 금치 못하겠습니다 ㅎㅎ (신기함 그 자체 ㅎㅎ!!)

그런데!! 만약 손을 사용할 수 없는 상태라면 G-speak 기술도 컴퓨터를 사용하기엔 무리가 있지 않을까요?

그래서 소개할 것이 ‘eyeCan’ 입니다.

최근 eyeCan은 삼성전자 창의개발 연구소에서 진행했던 프로젝트 인데요~~

이 기술은 일명 ‘안구 마우스’라고 불리운다고 합니다.

그런데 우리는 보통 마우스라면 이 그림을 생각하죠? ㅎㅎ

이 프로젝트의 핵심은 장애인의 컴퓨터에 대한 접근성을 향상시킨 다는 것 인데요!!

기존 제품에 비해 가격이 저렴하고 기능적으로 굉장히 혁신적인 제품인 것 같습니다.

삼성전자에 따르면 eyeCan'은 전신마비로 눈동자만 움직일 수 있는 사람도 자유롭게 컴퓨터를 쓸 수 있도록 제작 되었다고 합니다.

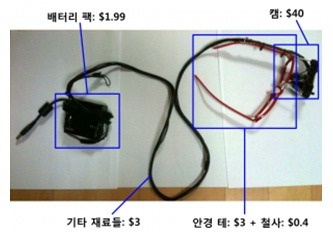

기존 안구마우스의 경우 시판 가격이 1,000만원을 넘었으나 이번에 개발된 'eyeCan'는 5만원 이내의 재료비로 제작이 가능하며, 필요한 사람은 누구나 공개된 매뉴얼과 소프트웨어를 통해 제품을 만들어 쓸 수 있도록 할 예정이라고 하네요. (삼성전자 제공)

또, 제품 수정과 개선도 비(非) 상업적인 용도로는 자유롭게 가능하다는 것이 특징이라니.. 정말 이 제품이야 말로 인간 친화적인 제품이 아닐까 생각합니다^^

<사진 : 삼성전자>

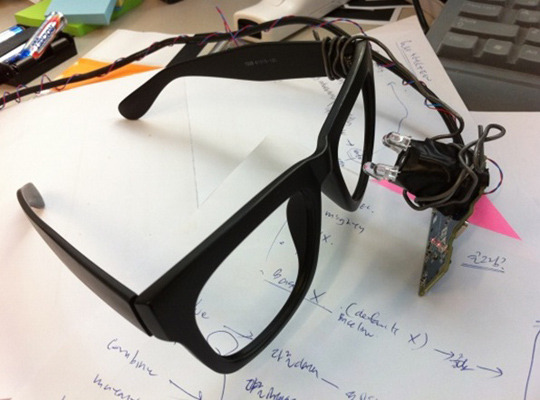

사실 eyeCan 은 안구마우스가 아닌‘eye input device’가 좀 더 과학적인 설명일 것 같은데요!

마우스와 동일하게 컴퓨터 환경을 사용하는 것 뿐 아니라 눈을 사용해서 컴퓨터를 사용하는 점을 감안해 키보드 없이도 쉽게 사용할 수 있도록 일부 어플리케이션에 대한 별도 개발을 하게 되었다고 합니다

<사진 : 삼성전자>

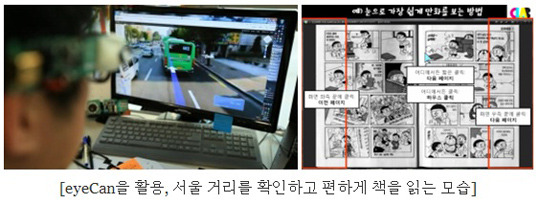

연구원들은 포탈사이트의 지도서비스( ex) 다음 로드뷰, 네이버 거리뷰 등)를 활용해 움직이지 못하는 환자분들이 원하는 곳에 직접 보고, 느낄 수 있도록 했으며~~ 또 눈으로 일일이 화살표를 찾아서 클릭하지 않고, 눈을 위로 올리면 앞으로 가고 옆을 보면 옆으로 바로 이동해 실제로 보는 것과 비슷한 느낌을 가질 수 있도록 했다고 하네요~~

또한 공개되어 있는 이미지 뷰어를 사용해 만화나 책 등을 볼 때 다음 페이지를 넘기기 위해 일일이 메뉴바, 또는 단축키를 눈으로 찾아서 움직이지 않게 페이지를 다 본 다음엔 오른쪽 끝부분에서 눈을 한 번 깜박이는 것으로 다음페이지로 넘어가게 하는 등

기존에 존재하는 API에 user experience를 고려한 xml화일을 덧붙여 eyeCan 사용자들이 좀 더 편하게 일반인과 동일한 인터넷 환경을 즐길 수 있도록 하였다고 합니다. (삼성전자 제공)

<사진 : 삼성전자>

아래 동영상은 eyeCan 개발과정을 담은 것인데요~~ 연구원들의 열정을 볼 수 있습니다.^^

정말 대단한 노력과 열정이 아닐까요 ^^ 개발자들에게 박수를 보냅니다.

<동영상 : 유튜브, 삼성전자>

오늘 ‘g-speak’ 기술과 ‘eyeCan’ 기술에 대해 알아보았는데요!

정말 기술이 미래 지향적이고 인간 친화적일때 우리의 삶을 정말 풍요롭게 만드는 것 같습니다!!

여러분은 혹시 이와 비슷하게 영화에서만 보던 미래 기술 혹은 인간 친화적인 기술을

알고 계신가요?

그럼 댓글로 정보 함께 공유해요~~!!

소중한 여러분의 아이디어와 정보가 많은 분들에게 꿈과 희망을 주길 기대합니다.^^